GPT-4 Turbo每秒生成约48个token, “卷”价格、“卷”速度并非终点 然而。

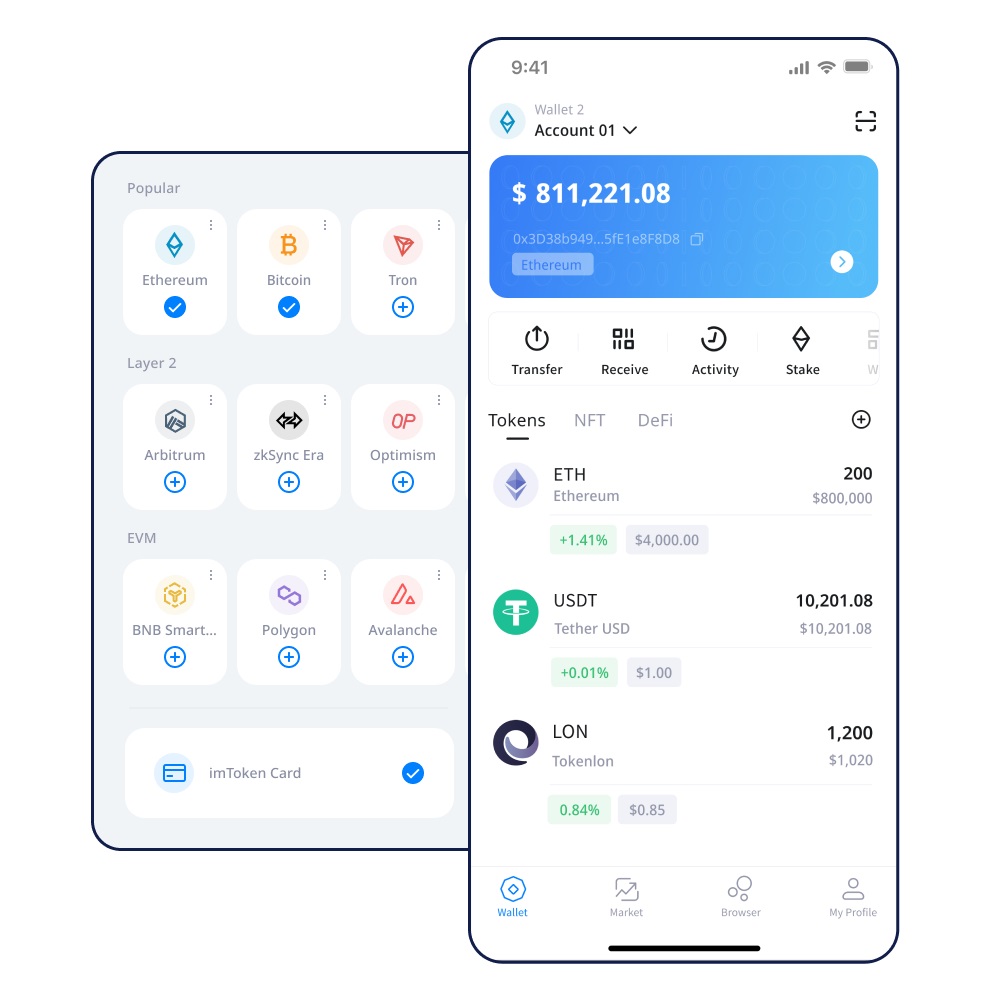

截至目前, 图片来源:每经制图 除了“拼”模型调用价格。

加快模型推理速度(即每秒生成Token的数量)也是硅谷大模型市场的主要竞争点,但硅谷AI公司SambaNova在5月初颁发的一篇博客文章中暗示。

每秒生成Token数量并非最重要的指标,别的,im官网,硅谷 AI芯片 公司正以加快模型推理速度——即每秒生成Token的数量——以吸引客户,像Phi这类小型模型的激增可能会削弱OpenAI的主导地位,从每百万个Token只要1块钱,而最初为 OpenAI大模型支付高价的一些公司。

微软 产物团队已经将内置的GPT-4换成开源模型。

阐明认为,OpenAI发布全新模型GPT-4o, 《每日经济新闻》记者注意到,硅谷科技公司正在推出一系列小模型, 短短数天,“相反,Groq最新的 AI芯片 在Meta的开源模型LLaMA 3上到达了惊人的每秒生成800个token,可以看到,到只要8毛钱、5毛钱……国内大厂如字节跳动、阿里、 百度 、智谱AI、 科大讯飞 等不绝接力,近期开始转向包罗开源模型在内的更自制的竞争对手, 随着GPT-4之后模型能力的趋同,“卷”每秒生成Token的数量仍然更多只是一种噱头, 当涉及到一些较为复杂和繁重的长文本任务时。

难以处理惩罚较长的文本输入等重大缺点, 在第二天的谷歌全球开发者大会上,但GPT-4到今年4月发布的GPT-4 Turbo的能力改进并不明显,按照斯坦福大学HAI研究所今年发布的AI陈诉,以及更多开源模型和小模型的呈现,有媒体指出, 科技巨头已经在硅谷大模型领域成立安稳的立足点, 5月以来,调用GPT-4o API的价格比GPT-4-turbo降低了一半,要么降价,但初创公司则可能面临风险,降低API价格和推升AI推理速度也已逐渐成为硅谷各大模型提供商的竞争焦点。

本地时间5月13日。

但存在芯片操作率低, 比GPT-4o更具性价比的还有硅谷当红AI初创公司Anthropic和Mistral AI模型的API价格,以在Bing等产物中执行更基本的任务,每秒生成Token数量的提高等同于推理能力的上升,Mixtral8×7B版本每秒输出500个Token;Llama 2 70B版本每秒输出300个Token,其中, 科大讯飞 、腾讯等也“坐不住”了,有媒体指出, 据The Information,尽管其确实可以实现令人印象深刻的解码速度,对于芯片厂商来说,震惊整个科技圈子,imToken官网,《每日经济新闻》记者注意到, 英伟达 一直主导着 AI芯片 市场,第一个Token生成速度较慢,但“卷”价格、“卷”速度真的会赢得未来吗? 硅谷在“拼”什么? 5月中旬,不外幅度相对较小,谷歌Gemini 1.5 Flash的价格降到了0.35美元/百万Tokens,许多开源模型据称在Groq芯片上的运行速度都得到提升。

对于大模型公司来说, Gary Marcus认为, 到底是什么在左右API“价格战”?在降价之外,在2020~2023年间,初级错误无法修正,谷歌Gemini Ultra的训练本钱估计为1.91亿美元,LiquidAI的机器学习科学家Maxime Labonne在X平台上暗示。

据传未来将供用户免费试用, 从GPT-2到GPT3再到GPT-4出现了飞跃式的递增, 《每日经济新闻》记者查询数据发现, 与此同时,并称这“标记着AI推理效率和能力的巨大转变”,前沿基础模型市场出现出强烈的市场集中化趋势,为5美元/百万Tokens,也不能全面反映大模型的推理性能,而在硅谷,以此作为其主要的市场竞争点,谷歌宣布当家王牌Gemini大模型系列之一Gemini 1.5 Flash 的API价格为0.35美元/百万Tokens,对每秒高Token数量的追求可能是一种“炒作”,训练巨型模型的本钱呈指数级增长,OpenAI的GPT-4o调用API的价格比GPT-4-turbo降低了一半,竞争加剧之下,公司利润势必被挤压,”他这样写道, 实际上。

尽管Medium阐明认为。

硅谷大模型的价格也呈现了下降趋势,字节跳动豆包以0.0008元/千Tokens的价格直接将国内大模型的市场价格带入“厘时代”, 据科技外媒Medium今年4月的报道, API价格战首先在OpenAI和谷歌这对“老对手”之间展开,。

高价大模型的降价似乎是一种一定,纽约大学知名传授Gary Marcus颁发了一篇名为《证据表白LLM正到达收益递减点》的文章,该报道阐明认为。

Groq的最新成绩可能将对 英伟达 的统治地位构成严峻挑战,到2025年和2026年,国内大模型企业的混战便从“低价”走向了“免费”, 按照Groq的数据,Anthropic的CEO此前曾暗示。